CogvideoX Image to Video Workflow

06.01.2025 18:14

MOD

TilesMo. 06 Jan. 2025, 18:14 Uhr

Hallo meine Lieben,

Ich habe ja für meine Songs fleissig mit AI Videofilme gebaut. Im Moment erstelle ich die mit ComfyUI. Und entsprechenden AI Modellen. Das war früher Deforum in Automatic1111, dann AnimateDiff in ComfyUI. Und Im Moment spiele ich mit der neuesten Video AI Gernation herum, genauer mit CogVideoX. Hunyuan würde ich zwar gern testen, aber das darf legal gar nicht in Europa verwendet werden. Es gibt keine Lizenz. Und zu LTX Video kam ich noch nicht.

ComfyUI ist eine Nodes basierte Frontendlösung um mit AI Bilder oder Videos zu erstellen. Sprich man muss sich seinen Workflow selber zusammenstöpseln. Und damit man nicht jedesmal bei Null anfängt kann man so einen Workflow natürlich auch speichern und laden.

Was einem so ein Workflow nicht abnehmen kann ist die ganze Umgebung einzurichten. Damit das funktioniert müssen die entsprechenden Nodes installiert sein.

Wenn man einen Workflow läd in dem die nötigen Nodes fehlen macht es einem ComfyUI zwar recht leicht. Die entsprechenden Nodes werden rot angezeigt, und können in der Regel dann einfach im Manager nachinstalliert werden. Aber es müssen die ganzen Weights und Loras und was man da noch alles braucht heruntergeladen werden und in den entsprechenden Ordnern stecken. Den Teil kann ich euch leider nicht abnehmen. Ihr müsst euch schon ein wenig in Comfy auskennen.

Die CogVideoX Version die ich hier verwendet habe ist noch die alte Version 1.1 mit limitierter Grösse. 720x480 Pixel. Und einer begrenzten Anzahl an Frames. 49. Die alte Version 1.1 deswegen weil das Motion Lora das ich hier verwende nicht mit der Version 1.5 funktioniert.

Das heisst man muss das ganze noch upscalen wenn man zum Beispiel 1920x1080 als Auflösung haben will. Dafür habe ich einen primitiven Upscaler mit an Bord. Erwartet aber keine Wunder davon.

Ihr benötigt eine Grafikkarte mit mindestens 12 Gb Vram. Ich habe CogVideo auf meiner alten Grafikkarte mit nur 8 Gb nie zum Laufen gebracht.

Damit kann man dann zum Beispiel so ein Video basteln:

https://www.tomgoodnoise.de/wp-content/uploads/2025/01/cogvideox-imagetovideo-tomgoodnoise.mp4

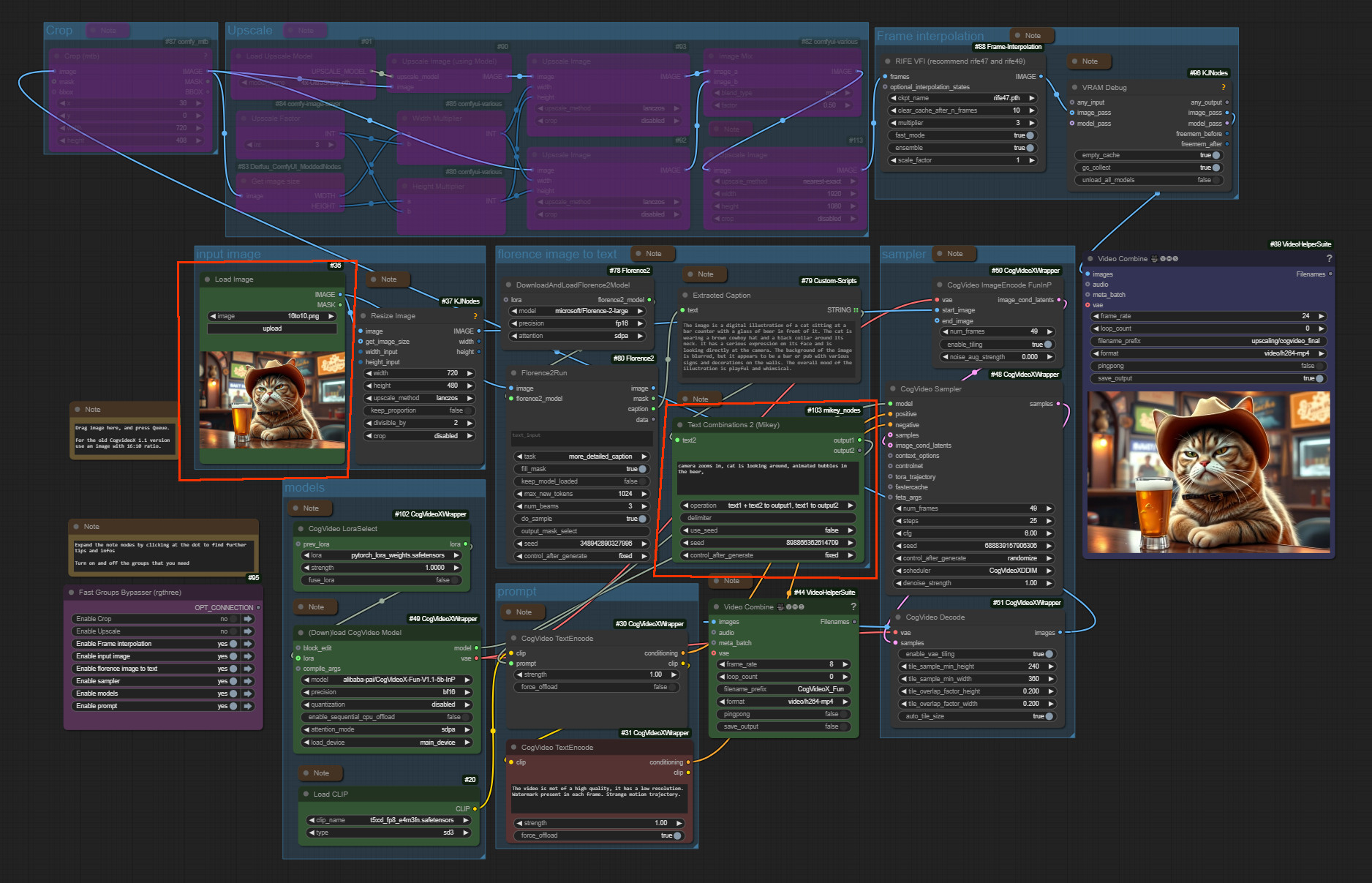

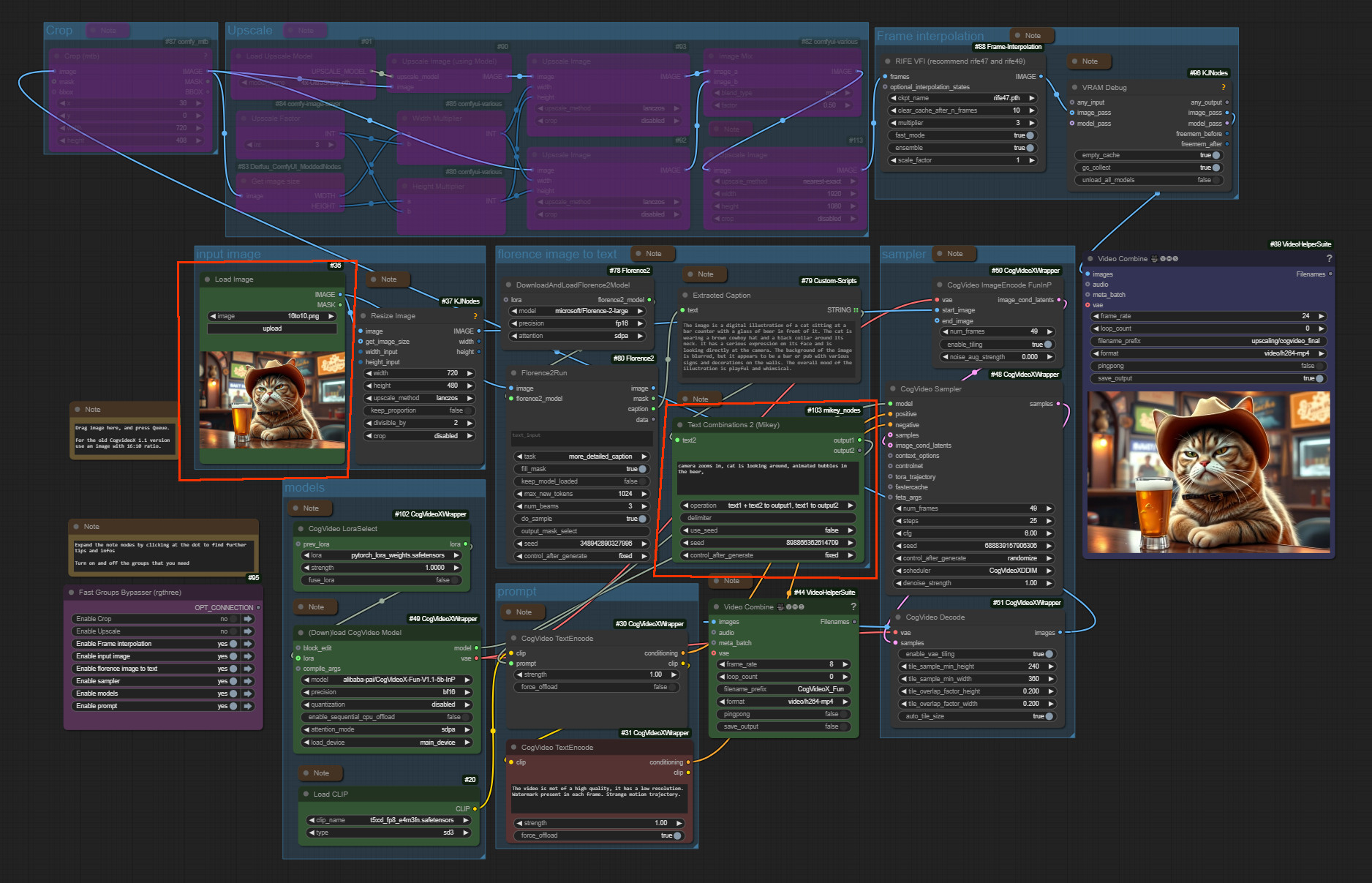

Und so sieht der Workflow aus:

Man läd ein Bild in Load Image. Passt den Prompt entsprechend an. Und drückt auf Queue. Und dann rennt das im Idealfall los und macht ein Video ...

Ich habe hier ein Camera Lora mit drin, sprich man kann zoomen oder seitwärts pannen. Und Cogvideo hört auf Bewegungsanweisungen. Manchmal zumindest. Die Katze schaut leider nicht um sich. Aber die Blasen im Bier sind ohne Anweisung nicht dabei ^^

Herunterladen kann man den Workfow hier. Knapp ein Mb. Json File und Startbild:

https://www.tomgoodnoise.de/index.php/ai/workflows/

Und ich denke ich werde die nächsten Tage auch noch mal ein Video machen und den Workflow näher erklären. Viel Spass damit

LG Tiles

Ich habe ja für meine Songs fleissig mit AI Videofilme gebaut. Im Moment erstelle ich die mit ComfyUI. Und entsprechenden AI Modellen. Das war früher Deforum in Automatic1111, dann AnimateDiff in ComfyUI. Und Im Moment spiele ich mit der neuesten Video AI Gernation herum, genauer mit CogVideoX. Hunyuan würde ich zwar gern testen, aber das darf legal gar nicht in Europa verwendet werden. Es gibt keine Lizenz. Und zu LTX Video kam ich noch nicht.

ComfyUI ist eine Nodes basierte Frontendlösung um mit AI Bilder oder Videos zu erstellen. Sprich man muss sich seinen Workflow selber zusammenstöpseln. Und damit man nicht jedesmal bei Null anfängt kann man so einen Workflow natürlich auch speichern und laden.

Was einem so ein Workflow nicht abnehmen kann ist die ganze Umgebung einzurichten. Damit das funktioniert müssen die entsprechenden Nodes installiert sein.

Wenn man einen Workflow läd in dem die nötigen Nodes fehlen macht es einem ComfyUI zwar recht leicht. Die entsprechenden Nodes werden rot angezeigt, und können in der Regel dann einfach im Manager nachinstalliert werden. Aber es müssen die ganzen Weights und Loras und was man da noch alles braucht heruntergeladen werden und in den entsprechenden Ordnern stecken. Den Teil kann ich euch leider nicht abnehmen. Ihr müsst euch schon ein wenig in Comfy auskennen.

Die CogVideoX Version die ich hier verwendet habe ist noch die alte Version 1.1 mit limitierter Grösse. 720x480 Pixel. Und einer begrenzten Anzahl an Frames. 49. Die alte Version 1.1 deswegen weil das Motion Lora das ich hier verwende nicht mit der Version 1.5 funktioniert.

Das heisst man muss das ganze noch upscalen wenn man zum Beispiel 1920x1080 als Auflösung haben will. Dafür habe ich einen primitiven Upscaler mit an Bord. Erwartet aber keine Wunder davon.

Ihr benötigt eine Grafikkarte mit mindestens 12 Gb Vram. Ich habe CogVideo auf meiner alten Grafikkarte mit nur 8 Gb nie zum Laufen gebracht.

Damit kann man dann zum Beispiel so ein Video basteln:

https://www.tomgoodnoise.de/wp-content/uploads/2025/01/cogvideox-imagetovideo-tomgoodnoise.mp4

Und so sieht der Workflow aus:

Man läd ein Bild in Load Image. Passt den Prompt entsprechend an. Und drückt auf Queue. Und dann rennt das im Idealfall los und macht ein Video ...

Ich habe hier ein Camera Lora mit drin, sprich man kann zoomen oder seitwärts pannen. Und Cogvideo hört auf Bewegungsanweisungen. Manchmal zumindest. Die Katze schaut leider nicht um sich. Aber die Blasen im Bier sind ohne Anweisung nicht dabei ^^

Herunterladen kann man den Workfow hier. Knapp ein Mb. Json File und Startbild:

https://www.tomgoodnoise.de/index.php/ai/workflows/

Und ich denke ich werde die nächsten Tage auch noch mal ein Video machen und den Workflow näher erklären. Viel Spass damit

LG Tiles

MOD

TilesDi. 07 Jan. 2025, 18:03 Uhr

Wie versprochen gibt es hier das Video zum Workflow. Leider nur in Englisch. Ihr dürft mich aber gern auf deutsch löchern

HerbieFr. 10 Jan. 2025, 14:48 Uhr

"die Blasen im Bier" - in den letzten 5 Sekunden sind die auch neben dem Bier. Aber am besten gefällt mir, daß es gerade ein Erdbeben gibt.

"Description

A image...."

Wenn auf das unbestimmte Fürwort ein Wort folgt, das mit einem Vokal beginnt, wandelt sich das "a" in "an"

Also: An image, an idea, an effort, an anchor etc.

"Description

A image...."

Wenn auf das unbestimmte Fürwort ein Wort folgt, das mit einem Vokal beginnt, wandelt sich das "a" in "an"

Also: An image, an idea, an effort, an anchor etc.

MOD

TilesSa. 11 Jan. 2025, 08:01 Uhr

Danke für die Anmerkung. Ich werde an meinem schlechten Englisch arbeiten

Ja, das ist immer wieder ein Überraschungsbonbon was hinten bei rauskommt ^^

"die Blasen im Bier" - in den letzten 5 Sekunden sind die auch neben dem Bier. Aber am besten gefällt mir, daß es gerade ein Erdbeben gibt.

Ja, das ist immer wieder ein Überraschungsbonbon was hinten bei rauskommt ^^

© 3D-Ring - deutsche 3D Software Community, Archiv 2001 - 2006